Anthropique

Mardi, Anthropic introduit Claude, un grand modèle de langage (LLM) qui peut générer du texte, écrire du code et fonctionner comme un assistant IA similaire à ChatGPT. Le modèle trouve son origine dans des préoccupations fondamentales concernant l’avenir Sécurité de l’IA et Anthropic l’a formé en utilisant une technique qu’il appelle “IA constitutionnelle.”

Deux versions du modèle AI, Claude et “Claude Instant”, sont disponibles dès maintenant pour un “Accès anticipé” et aux partenaires commerciaux d’Anthropic. Ceux qui y ont accès peuvent utiliser Claude via une interface de chat dans la console de développement d’Anthropic ou via une interface de programmation d’application (API). Avec l’API, les développeurs peuvent se connecter à distance aux serveurs d’Anthropic et ajouter l’analyse de Claude et capacités d’achèvement de texte à leurs applications.

Anthropic affirme que Claude est “beaucoup moins susceptible de produire des sorties nuisibles, plus facile à converser et plus orientable” que les autres chatbots d’IA tout en maintenant “un degré élevé de fiabilité et de prévisibilité”. L’entreprise cite des cas d’utilisation tels que la recherche, la synthèse, l’écriture collaborative et le codage. Et, comme API de ChatGPTClaude peut changer de personnalité, de ton ou de comportement en fonction de ses préférences d’utilisation.

Une vidéo promotionnelle mettant en vedette Claude d’Anthropic.

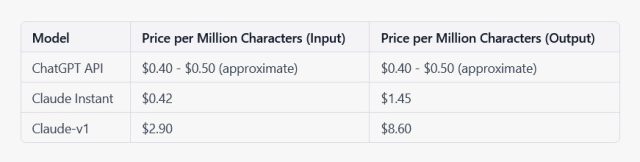

Pour vendre Claude, Anthropic facture l’utilisation par million de caractères entrants et sortants. Alors que le modèle d’IA gpt-3.5-turbo d’OpenAI coûte 0,002 USD pour 1 000 jetons (fragments de mot), Claude Instant est disponible pour 0,42 USD par million de caractères en entrée rapide et 1,45 USD par million de caractères pour la sortie. “Claude-v1”, le plus grand modèle, coûte 2,90 $ par million de caractères entrés et 8,60 $ par million de caractères sortis. Bien qu’il n’y ait pas de conversion standard entre les jetons et les caractères, notre calcul au fond de l’enveloppe est que l’API ChatGPT d’OpenAI coûte environ 0,40 $ à 0,50 $ par million de caractères, donc Claude est plus cher en général.

Ars Technica

Selon Anthropic, Claude a déjà été intégré dans plusieurs produits disponibles via des partenaires, tels que Aide au canard résumés instantanés de DuckDuckGo, une partie de Notion IAet une application de chat IA appelée Poë qui a été créé par Quora.

L’ancien vice-président de la recherche OpenAI, Dario Amodei, et sa sœur Daniela ont fondé Anthropic en 2021 comme “une société de sécurité et de recherche sur l’IA” après un désaccord sur l’orientation de plus en plus commerciale d’OpenAI. Amodi a amené d’autres membres du personnel d’OpenAI tels que Tom Brown, qui a dirigé les travaux d’ingénierie sur GPT-3. UN révision de GPT-3 a ensuite servi de modèle de langage fondamental au cœur de ChatGPT. Selon Le bordGoogle a investi 300 millions de dollars dans Anthropic fin 2022 en échange de 10 % de l’entreprise.

D’après les plans annoncés par Google pour Barde et le Palmier API, il semble peu probable que Google s’appuie sur Anthropic pour les solutions d’IA dans ses produits, mais financer un rival d’OpenAI pourrait être dans l’intérêt stratégique de Google à l’avenir. Pour l’instant, Anthropic prévoit de poursuivre le développement et l’amélioration de Claude.

“Nous prévoyons d’introduire encore plus de mises à jour dans les semaines à venir”, écrit Anthropic. “Au fur et à mesure que nous développerons ces systèmes, nous travaillerons continuellement pour les rendre plus utiles, honnêtes et inoffensifs à mesure que nous en apprendrons davantage grâce à nos recherches sur la sécurité et nos déploiements.”